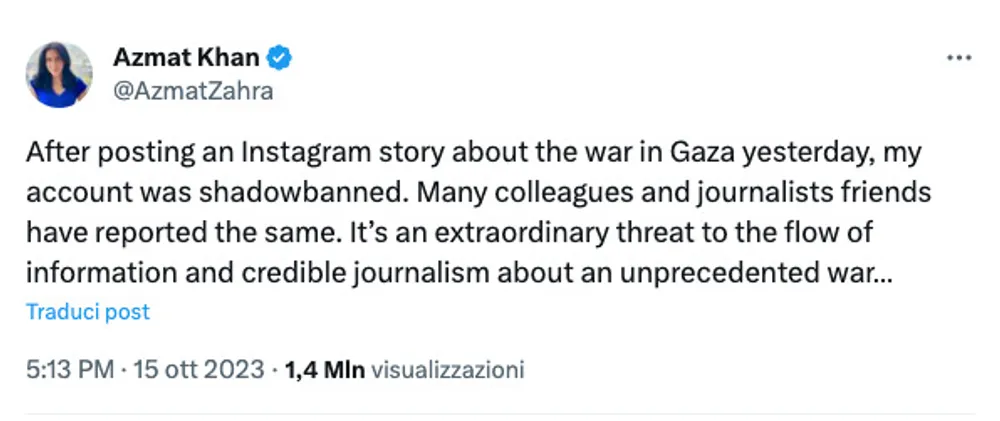

Negli ultimi giorni molti utenti sui social, e in particolare quelli di Meta (Facebook e Intagram), hanno segnalato un numero di visualizzazioni molto inferiori alla norma per i contenuti che contengano parole chiave legate alla Palestina, a Gaza e all’apartheid palestinese. Storie tra le zero e le due visualizzazioni, profili di giornalisti e attivisti chiusi e oscurati. È il caso di Karem Rohana, italo-palestinese bloccato a Gerusalemme, dove era in vacanza, nonostante le ripetute richieste di aiuto inviate alla Farnesina. Il suo profilo Instagram è stato chiuso alcuni giorni fa. Ma è un’esperienza che coinvolge anche pagine e profili personali che ripostano questo tipo di contenuti: è successo a un video di Medicisenzafrontiere circolato molto e che è stato oscurato nelle storie di chi lo ha condiviso. Tanto che alcune pagine di meme e di satira politica hanno cominciato a ingegnarsi. È il caso di Madonnafreeeda che ha ironizzato: "Meglio una vita in shadowban che un giorno in silenzio sulla violenza dell'illegittimo stato di Ischia sul popolo di Predappio" o "Inammissibile la reazione di Iglesias che ha deciso di tagliare acqua, cibo ed elettricità alla striscia di Grosseto". È la cosiddetta "algolingua" che nasce in rete con l'obiettivo preciso di ingannare i sistemi di moderazione dei contenuti basati sugli algoritmi delle piattaforme social più utilizzate, quali TikTok, Youtube, Instagram e Twitch. Anche la giornalista Azmat Khan del New York Times, vincitrice del Premio Pulizter 2022, ha dichiarato che le sue storie su Instagram sulla situazione a Gaza sono invisibili ai follower.

La polemica sull'invisibilizzazione dei contenuti sulla Palestina da parte delle piattaforme non è nuova, anche se quello che sta avvenendo in questi giorni la rende particolarmente evidente: nel 2019, l’organizzazione “ImpACT International for Human Rights Policies”, con sede a Londra, ha accusato Israele di “sfruttare i suoi rapporti con l’azienda di Facebook per combattere i contenuti palestinesi nel cyberspazio blu”. Nel 2018 il ministero della Giustizia israeliano aveva annunciato che l’amministrazione di Facebook, l’anno precedente, aveva risposto a quasi l’85% delle richieste israeliane di rimozione di account e di accesso a dati sui contenuti palestinesi presenti nello spazio di Facebook. Ma al di là di qualsiasi speculazione, rimane da chiarire in che modo funzioni lo shadowban e quale sia il ruolo di Meta in questo esercizio di oscuramento di contenuti sui social.

Comunemente l’abbassamento delle visualizzazioni social, l’oscuramento di profili e dei contenuti e la bassa visibilità rientrano sotto il nome di “shadowban”, letteralmente "ban ombra", che fa riferimento alla pratica utilizzata su piattaforme social come Instagram, in cui i contenuti postati da un determinato utente vengono nascosti o resi meno visibili agli altri.

Come spiega Francesca Scapolo, Content and Social Media Lead presso Oversight Board, un organismo di supervisione indipendente che decide sui ricorsi degli utenti di Facebook e Instagram, tutelando libertà di espressione e diritti umani: «La moderazione sui social è molto complessa, c'è la questione del bilanciamento tra tutela della libertà di espressione e l'arginare la diffusione di informazioni false. Ci sono pratiche molto evidenti come la rimozione di profili e di contenuti, azioni che hanno l'obiettivo di eliminare del tutto l'engagement. Invece quando si parla di shadowbanning sembra quasi una punizione segreta, non si sa cosa succede, fino a che punto le visualizzazioni sono diminuite, quali sono i diritti degli utenti sulle piattaforme. Non c'e una chiara definizione di shadowbanning, è un concetto che si rifà a come i contenuti vengono raccomandati dalle piattaforme più che a una moderazione in senso classico. Ci sono diversi algoritmi che giocano una parte importante in questa dinamica».

Quello a cui gli utenti dei social stanno assistendo in questi giorni solleva alcune questioni cruciali che riguardano il modo in cui le piattaforme stanno gestendo l’accesso e la condivisione delle informazioni e la moderazione dei contenuti online, anche per l’impatto del Digital Services Act, il nuovo regolamento europeo sulle piattaforme entrato in vigore il 25 agosto, ma anche la linea di demarcazione tra la prevenzione alla disinformazione e, di fatto, l'effetto censura. Non è semplice ricostruire questi passaggi perché le regole della moderazione di Meta su come sia istruito l'algoritmo per mostrare o nascondere contenuti non sono pubbliche. Tuttavia l'esperienza di basse visualizzazioni a seguito della condivisioni di certe parole e immagini è reale e dipende da una moderazione dei contenuti problematica.

Nella pratica, il sistema di moderazione dei contenuti social di Meta, come ha chiarito Donata Columbro, esperta di dati e di nuove tecnologie e autrice di "Dentro l'algoritmo" (effequ 2022) «si basa in gran parte sul lavoro manuale di centinaia di persone, donne e uomini che passano le giornate a guardare video e foto violenti e disturbanti da segnalare come “non pubblicabili” o “da verificare”, insieme ad altre etichette che aiutano l’algoritmo a imparare in modo automatico come gestire i contenuti». Le procedure di moderazione dei contenuti sono documentati da molti testi, come "La rete non ci salverà" di Lilia Giugni (Longanesi 2022), "Schiavi del clic" di Antonio Casilli (Feltrinelli 2020) e "Gli obsoleti" di Jacopo Franchi (Agenzia X, 2021). «Anche se non si tratta di una censura in senso stretto, l'effetto è quello della censura per alcuni contenuti, e questo è un problema» spiega Columbro. « I filtri alle parole permettono di fare una scrematura molto grossa. La mia ipotesi e che in situazioni di crisi in cui viene prodotto moltissimo contenuto segue un abbassamento della soglia dei contenuti ritenuti a rischio, per prevenire l'hate speech o la diffusione di contenuti violenti. Credo ci sia stato un'innalzamento di allerta che penalizza alcune parole».

Questa settimana l'Unione Europea ha lanciato un avvertimento a Musk, proprietario di Twitter/X, e all'amministratore delegato di Meta, Mark Zuckerberg, invitandoli a rimuovere qualsiasi contenuto che violasse le leggi dell'UE e chiedendo loro di rispondere entro 24 ore. L'amministratore delegato di X, Linda Yaccarino, ha annunciato giovedì che la piattaforma ha rimosso centinaia di account legati ad Hamas e ha etichettato decine di migliaia di post. Meta ha risposto venerdì in un post sul blog, annunciando di aver creato un centro operativo speciale per la moderazione dei contenuti specificamente per i post in ebraico e arabo e di aver rimosso un gruppo di falsi account Facebook e Instagram collegati a una precedente operazione di disinformazione di Hamas. Inoltre, l'azienda ha dichiarato di aver rimosso o etichettato 795.000 contenuti come "disturbanti", che limitano la portata di un post, dall'inizio del conflitto il 7 ottobre. Ma a seguito delle proteste degli utenti sullo shadowban dei contenuti sulla Palestina, Andy Stone, portavoce di Meta, ha dichiarato che si è trattato di un bug (in teoria già risolto) e che il problema avrebbe interessato gli account in tutto il mondo, non solo quelli che hanno pubblicato contenuti sulla guerra.

«La questione del Digital Services Atc è in questo senso interessante» continua Francesca Scapolo. «È la prima legislazione che cerca di creare una giurisprudenza attorno allo shadowbanning, che è esplicitamente menzionato dalla legge. Nell'articolo 17 si chiede alle piattaforme di fornire delle informazioni agli utenti sul motivo degli oscuramenti. E nel Transparency Database della Commissione Europea, attivo dal 25 settembre, ci sono già 93 milioni di contenuti che sono stati rimossi o per cui c'e stata una restrizione. E parliamo solo delle grandi piattaforme. A seguito della lettera di Thierry Breton, commissario europeo per il mercato interno e i servizi, che richiedeva a Meta e a X che cosa stessero facendo per arginare la disinformazione sulla guerra, Meta ha pubblicato un blog con le misure prese, dicendo che stanno limitando la visibilitaà di certi contenuti, per evitare che i contenuti violenti o che incitano all'odio, abbiano visibilità. Ma ci sono persone che utilizzano i social per condividere testimonianze di violazioni di diritti umani che vengono rimossi».