Ma la notizia non è che la nostra era iperconnessa sia stata conquistata dagli algoritmi: è che quegli stessi algoritmi non sono affatto neutri e oggettivi come siamo inclini a credere. E anzi discriminano, come e più dei decisori in carne e ossa che si propongono di correggere. Per questo la comunità accademica ha cominciato a chiedersi seriamente come e perché gli algoritmi mantengano le disuguaglianze sociali esistenti, e anzi ne creino di ulteriori.

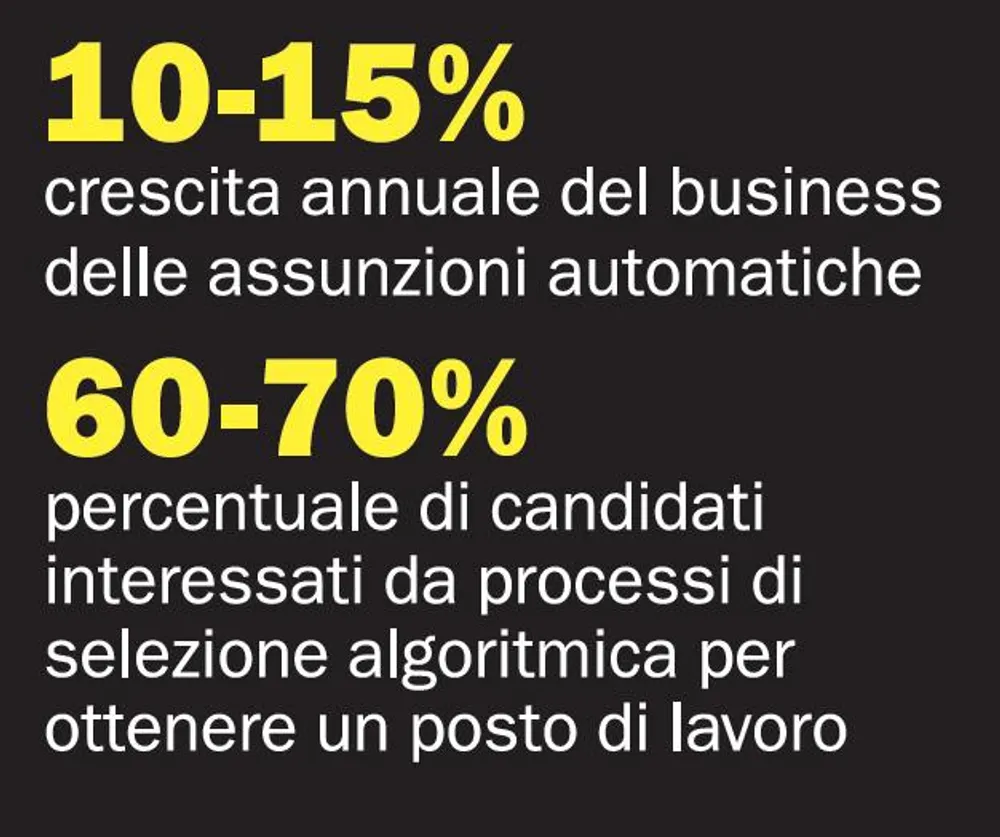

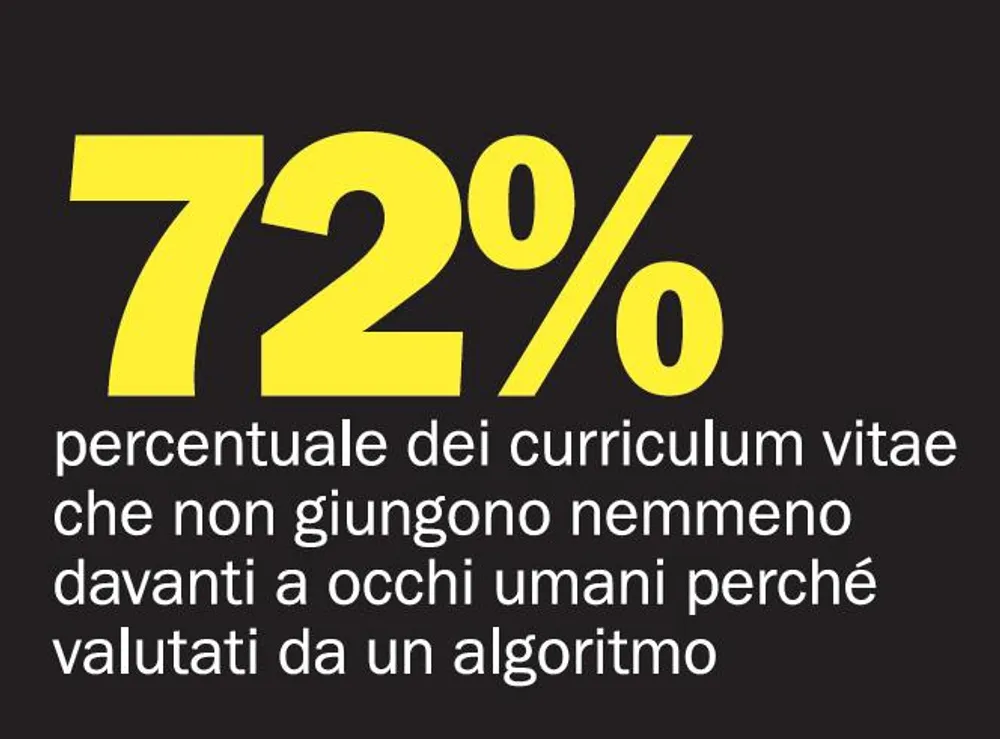

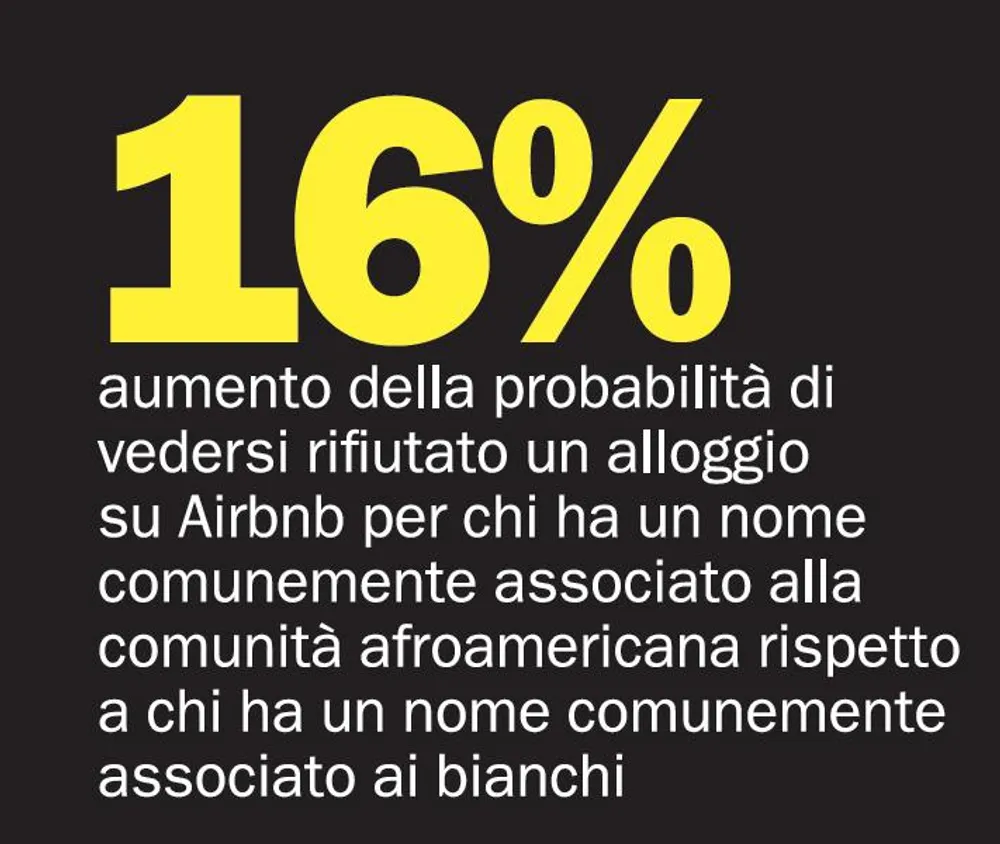

«Non è solo lo scrutinio pubblico a mancare», ha scritto la prestigiosa rivista "Nature" nell’editoriale del 21 settembre: «Mancano le regole e le salvaguardie che governano ogni altro aspetto della vita democratica». Così ad esempio la polizia continua a concentrarsi in modo sproporzionato sui crimini nei quartieri disagiati, ignorando quelli dei ricchi. Le sentenze sono più dure per gli afroamericani. Le donne sono meno esposte degli uomini a pubblicità on line per lavori ben retribuiti. E più in generale chi sbaglia risposta in un test di personalità, o ha più amici sui social network giudicati per qualche ragione più "a rischio", rischia di faticare a trovare lavoro o a ottenere un prestito per il resto dei suoi giorni - senza nemmeno sapere quali e quante aziende disporranno dei suoi dati, né come esattamente li valuteranno.

Insomma gli algoritmi, scrive Cathy O’Neil nel recentissimo saggio "Weapons of Math Destruction", «sbattono la porta in faccia a milioni di persone, spesso per le ragioni più insulse, e non offrono possibilità di appello».

Altro che equità garantita dal digitale: «Sono ingiusti», conclude la studiosa, e rappresentano «una minaccia crescente». Perché incorporano «obiettivi e ideologie», senza che siano esplicite o anche solo visibili. E perché producono "feedback loop" che rinforzano, invece di smentirli, i pregiudizi esistenti: un giovane che resta disoccupato per una cattiva decisione di un algoritmo farà ancora più fatica a trovare lavoro; un condannato a una pena severa avrà maggiori probabilità di commettere ulteriori crimini. E così via.

Se poi l’algoritmo dovesse avere sbagliato, non c’è attualmente modo di farglielo notare: quando un programma commette un errore, in altre parole, non ne paga le conseguenze; quelle sono tutte a danno degli umani che giudica. E che tuttavia non sembrano rendersi conto del pericolo. Come mai? «È una combinazione di terrore e fiducia», risponde O’Neil a "l’Espresso". «Temiamo la tecnica, perché come società siamo stregati da ciò che è matematicamente complesso. Ma allo stesso tempo riteniamo la matematica qualcosa di vero e al di là della moralità». Non che non meriti fiducia, prosegue O’Neil: «è che gli algoritmi non sono pura matematica. Sono piuttosto opinioni umane incastonate in linguaggio matematico, e non meritano necessariamente la nostra fiducia».

Il reale problema è che non siamo nemmeno in grado di apprezzare davvero quanto profonde siano le sfide portate da quei cattivi modelli matematici all’equità e, secondo l’autrice, la democrazia stessa. Se gli algoritmi non sono trasparenti, e i bias, le distorsioni si annidano in modi imprevedibili all’interno dei dati che computano, ciò che sappiamo non è che la punta dell’iceberg. Ma è ancora peggio: non solo quell’opacità è protetta come "proprietà intellettuale" dalle molteplici aziende che, dalla pubblicità al calcolo del rischio assicurativo, prosperano grazie agli algoritmi; negli Stati Uniti potrebbe perfino essere illegale tentare di addentrarvisi, per fare luce su cosa realmente avvenga nel mondo delle decisioni automatiche.

Colpa del Computer Fraud and Abuse Act, la stessa criticatissima legge anti-hacking usata per incriminare il giovane attivista Aaron Swartz, poi suicidatosi. La norma infatti proibisce di violare le condizioni di utilizzo delle piattaforme on line: sarebbe a questo modo illecito creare identità fasulle, dare informazioni scorrette sul proprio account o usare metodi automatici di raccolta massiva di dati, per esempio i risultati di ricerca. Eppure senza è impossibile svolgere ricerca sulla discriminazione algoritmica, argomenta Christian Sandvig, docente dell’Università del Michigan che insieme a un gruppo di colleghi, e con il supporto dell’American Civil Liberties Union, ha fatto causa al governo Usa per assicurarsi che l’attività accademica non finisca per essere considerata reato.

La sentenza, dice Rachel Goodman dell’Aclu, potrebbe arrivare tra uno o sei mesi, ma intanto lo stesso Sandvig concorda con O’Neil: «È di certo possibile che la discriminazione algoritmica sia molto diffusa», più di quanto sappiamo. «La gran parte delle nostre conoscenze attuali», risponde, «proviene da case study». Ovvero, da colpi di fortuna: un giornalista che si imbatte in un nuovo esempio di ingiustizia, o un gruppo di ricercatori che produce nuove evidenze empiriche. Ed è per questo, prosegue, «che c’è bisogno di più ricerca sistematica. È esattamente questo il problema che cerchiamo di affrontare».

Difficile, con lo spettro costante di ripercussioni legali che potrebbero applicarsi perfino ai ricercatori di aziende che operano fuori dagli Stati Uniti - basta vi abbiano sede - o a singoli che abbiano anche solo visitato il paese. Non stupisce dunque che la comunità accademica stia cercando di fare quadrato e affrontare la questione a viso aperto. Da più parti, infatti, si parla ormai di un vero e proprio "movimento" per responsabilizzare gli algoritmi e renderli etici, o quantomeno compatibili con valori fondamentali come l’uguaglianza e il rispetto della dignità personale.

È un nuovo e cruciale scontro tra valori: da un lato l’efficienza, dall’altro l’equità. E la soluzione va trovata al più presto. Suresh Venkatasubramanian, docente all’Università dello Utah, è in prima linea tra chi si batte per conciliare algoritmi e giustizia sociale. «Ci sono diverse iniziative collettive e un numero crescente di contributi proveniente da diversi ambiti della computer science. Siamo tutti in contatto tra noi, e cerchiamo di avanzare su più fronti: scoprire bias negli algoritmi e provare a correggerli, capire la natura delle decisioni algoritmiche e costruire strumenti per spiegarle agli esseri umani, inventare procedure per scoprire decisioni scorrette».

Sono questi anche gli obiettivi promossi dal workshop annuale chiamato Fairness, Accountability and Transparency in Machine Learning, una delle occasioni che riunisce la comunità accademica - il prossimo è previsto il 18 novembre alla Columbia, a New York. Ma, scrive O’Neil, gruppi di lavoro sull’argomento sono nati anche al Mit di Boston, al Carnegie Mellon, e a Princeton, il cui Web Transparency and Accountability Project ha cominciato a creare bot, finti utenti automatici, di ogni tipo - maschi, femmine, ricchi, poveri, soggetti con disturbi mentali - per verificare il trattamento ricevuto in termini di discriminazione algoritmica.

Ma la vera sfida è culturale, opporsi cioè a una società che ha finito per digerire l’idea che il proprio ranking in un sistema di classificazione automatico, irresponsabile, ingiusto e opaco diventi sinonimo del proprio destino umano, sociale e professionale. È il rovescio della medaglia di una quotidianità fatta di sistemi reputazionali per ogni cosa, dal ristorante in cui consumare una cena romantica alla propria influenza online, passando per i siti e le app di appuntamenti e, domani, la propria stessa salute fisica e mentale. La quantità di correlazioni tra aspetti apparentemente tra loro del tutto scollegati delle nostre esistenze è difficile anche solo da pensare; ciò che invece possiamo già immaginare, perché accade, è cosa significhi finire in decine, centinaia di categorie che ignoriamo, ciascuna a uso e consumo di un diverso utilizzatore: chi vuole ridurre la capacità di un individuo a gestire il proprio denaro a un "e-score", un punteggio elettronico dell’affidabilità creditizia, per esempio, può già farlo; e lo stesso vale per il preside che vuole associare un numero a un insegnante per capire se merita di continuare a insegnare, nel prossimo anno accademico; o il poliziotto che deve decidere dove concentrare le sue attenzioni - di solito, per gli algoritmi, sono le periferie meno agiate.

In questo modo finiamo per essere giudicati non sulla base di chi siamo, ma a chi somigliamo, o da dove veniamo, o in cosa crediamo. Nel tritacarne algoritmico, l’individuo diventa sacrificabile alle regolarità di gruppo; e se fa eccezione, peggio per lui. Questa, insegnano la sociologia e la storia, è la matrice di ogni razzismo, di ogni ingiustizia sociale. La sfida lanciata ai ricercatori, dunque, è immane. Si tratta infatti di mostrare scientificamente che rivestire i pregiudizi di un’apparenza statistica non li rende meno pregiudizi; che i dati, in altre parole, non sono da soli garanzia di scientificità e correttezza. Ma si chiede loro anche di darci buoni motivi per porre in questione il fondamento economico e sociale del nostro vivere collettivo: la personalizzazione di tutto sulla base delle nostre tracce digitali. E l’idea che digitale sia sinonimo non solo di efficace, ma anche di buono e giusto.