Filosofia e scienza non bastano, al futuro serve l’algoretica

In attesa di una regolamentazione delle nuove tecnologie, i grandi operatori globali si sono riuniti e hanno dato vita a una carta etica per rendere più umana l'intelligenza artificiale. Parla il teologo Paolo Benanti, che ha coordinato il tavolo di lavoro internazionale

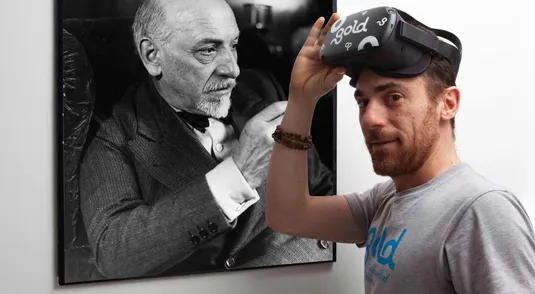

Se Ibm e Microsoft firmeranno la carta etica per rendere l’intelligenza artificiale più umana, in buona parte sarà merito suo. Nell’ultimo anno e mezzo Paolo Benanti, docente di Teologia morale e Bioetica all’Università Gregoriana, ha coordinato il tavolo di lavoro della Pontificia Accademia per la Vita - una dozzina di esperti del mondo accademico, italiano e internazionale, esponenti dell’industria tecnologica e del sindacato - che ha scritto, letto, discusso e limato il documento.

Professor Benanti, che valore ha questa carta etica?

«È il frutto di un percorso condiviso con i grandi player dell’industria. Non un punto di arrivo e neanche un decalogo scritto su pietra, bensì una chiamata per tutti gli uomini di buona volontà affinché la tecnologia resti umana. In un contesto in cui il decisore politico non ha ancora varato delle leggi, alcuni operatori tecnologici e istituzioni come la Pontificia Accademia per la Vita ragionano su questi temi, prima che vengano regolamentati».

L’ultimo film di Ken Loach, “Sorry we missed you”, racconta la vita infernale di un corriere, Ricky, oppresso dalla dittatura dell’algoritmo che regola le sue consegne. È una fotografia realistica?

«L’industria informatica ha prodotto una nuova cultura, un nuovo modo di abitare il mondo. Una delle più grandi trasformazioni attraversa il mondo del lavoro, che si disintermedia mentre appare un nuovo attore sociale, l’algoritmo, e nuove forme di potere: le piattaforme digitali. Con la sua grande capacità narrativa, Ken Loach fotografa cosa significa oggi lavorare per un algoritmo che tende a ottimizzare il nostro processo produttivo. Con la scusa di considerare le persone “imprenditori di se s tessi” si introducono nuove forme di lavoro a cottimo senza tutele».

Nel suo saggio “Il capitalismo della sorveglianza” (Luiss University Press), Shoshana Zuboff sostiene che le multinazionali digitali sfruttano, rubano i nostri dati personali senza chiedercelo. È d’accordo?

«Tutti noi siamo felici di ricevere servizi gratuiti, come le app di navigazione. Perché un tempo per una applicazione ci chiedevano 50 euro all’anno e oggi è gratis? Risulta evidente che il costo del servizio è la app stessa. Non ci siamo resi conto che tutto il nuovo mercato digitale, basato sulla nostra produzione di dati, ci considera risorse da consumare. Ma siccome l’uso sbagliato di queste ultime, come si è visto con l’ambiente, ci ha portato alla situazione attuale, bisogna chiedersi: quale regole occorre mettere in atto per evitare che accada alle persone ciò che è accaduto alle risorse naturali?».

Di fronte a questo diluvio tecnologico è urgente la questione etica.

«Se le macchine riescono a surrogare l’uomo in tante decisioni, dobbiamo chiederci con quali criteri può avvenire questa surrogazione. In altre parole, se la macchina commette un errore chi è responsabile? L’etica diventa il guard rail che ci permette di convivere in modo più sicuro con queste macchine sapienti. L’etica, però, è una questione di valori difficili da comunicare alle macchine, che funzionano sulla base di numeri. E allora bisogna mettere insieme algoritmi ed etica. Da qui nasce un nuovo termine, l’algoretica, la nuova disciplina che vorrebbe rendere le macchine capaci di computare princìpi tipicamente umani. Un percorso che coinvolge più discipline: non bastano più filosofia, tecnologia, informatica, serve la contaminazione».