Innovazione

14 gennaio, 2026Il colosso digitale guidato da Mark Zuckerberg ha deciso di rinunciare al suo programma di fact-checking. E il contrasto a ingerenze politiche e manipolazioni si fa sempre più debole

E ora chi deciderà cosa è vero? E secondo quali regole? Con la fine del Third party fact-checking program (3Pfc) di Meta, decisa da Mark Zuckerberg, si apre una fase di incertezza radicale sul controllo dei contenuti online. Accade nel pieno di una fase geopolitica instabile come non accadeva dagli anni della Guerra fredda. E nella quale la disinformazione gioca un ruolo chiave. Fin dal 2016 il 3Pfc affidava a organizzazioni indipendenti e certificate la verifica dei contenuti pubblicati su Facebook, Instagram e Threads. Al posto delle sentinelle sulla autenticità dei contenuti è stato introdotto un nuovo modello basato esclusivamente sulle Community notes – lo stesso già utilizzato da X – in cui il controllo della veridicità delle informazioni viene affidato direttamente agli utenti.

Secondo il Ceo di Meta, questa scelta, annunciata già all’inizio del 2025, si è resa necessaria a causa degli interventi politicamente orientati dei fact-checker e della loro presunta attività di censura sui social. Le ricadute, ovviamente, sono globali. E in Europa è già nel mirino il Digital services act, la legge comunitaria che rende obbligatorio il fact-checking per le piattaforme. Tanto che le principali organizzazioni di tutela dell’informazione, European fact-checking standards network (Efcsn) e International fact-checking metwork (Ifcn), sono scese in campo denunciando i rischi.

«Quello di Zuckerberg è un giudizio scorretto, dato che gli strumenti delle piattaforme di fact-checking non hanno mai permesso di censurare nulla», spiega Mauro Bomba, ricercatore in Sociologia dei processi culturali e comunicativi della Sapienza di Roma, che studia da vicino l’attività dei fact-checker. «L’unica azione consentita – puntualizza – è la verifica». Il potere di rimozione dei contenuti, infatti, era e resta una prerogativa totalmente in mano alle piattaforme social. I fact-checker erano già stati limitati nelle loro attività, dato che all’interno dei vincoli del 3Pfc «non potevano verificare contenuti pubblicati da account politici, passando da un ruolo di watchdog a quello di semplici moderatori».

La fine del 3Pfc negli Usa, prosegue Bomba, corrisponde anche a meno risorse finanziarie a sostegno delle organizzazioni di fact-checking, riducendone così l’operatività e in definitiva il ruolo di vigilanza democratica, perché «dove la democrazia è debole l'informazione è più manovrabile, più soggetta a influenze estere, a manipolazioni dei politici e della stampa connivente con la politica».

E l’alternativa non offre adeguate garanzie. «Il sistema delle Community notes intende la verità come assenso e negoziazione sociale», spiega Luca Serafini, ricercatore in Scienze politiche e sociali dell’Università degli studi di Firenze: «Una nota, infatti, viene pubblicata solo se riceve consenso da utenti eterogenei per caratteristiche e opinioni». La conseguenza, chiarisce Serafini, è che per i contenuti oggetto di debunking (bufale chiare e dimostrabili), utenti polarizzati e con pregiudizi potrebbero facilmente non raggiungere un accordo. In tal modo la bufala continuerebbe a circolare indisturbata. Così le Community Notes rischiano di rendere ancor più debole il contrasto alle ingerenze politiche esterne, in un clima sempre più complesso viste le minacce e l’instabilità che stanno attraversando il Medio Oriente e l’Est Europa. Come osserva Bomba, «l’info-war è un fatto, la disinformazione crea un vantaggio politico, e talvolta anche militare».

Tanto più, aggiunge Bomba, che Meta ha dimostrato già in passato di mutare policy in risposta alle pressioni politiche e reputazionali, più che per il riconoscimento di una reale tossicità dell’ecosistema informativo. Il punto centrale, sottolinea, è che «la disinformazione, la polarizzazione e le influenze esterne sono legate ai modelli di business delle piattaforme». Il funzionamento stesso degli algoritmi, costruiti per premiare la viralità e il coinvolgimento emotivo, favorisce un terreno esposto alle strategie di guerra cognitiva, dato che si alimenta proprio attraverso la diffusione di contenuti divisivi e la formazione di sfere polarizzate.

Fabio Giglietto, professore di Sociologia dei processi culturali e comunicativi dell’Università di Urbino Carlo Bo ha condotto uno studio sulle pagine Facebook dei parlamentari italiani dal quale emerge l’impatto degli algoritmi sui contenuti. Dal 2021, quando Meta annuncia di voler ridurre il peso dei contenuti politici nei feed di alcuni Paesi, tutte le metriche legate al discorso politico hanno subito un calo evidente. E in Italia che pure non rientrava tra gli Stati ufficialmente coinvolti, le visualizzazioni medie dei post politici sono passate da circa 70mila a 15mila per post; le condivisioni da 175 a 35; le reazioni da 1.000 a 250; e i commenti da 250 a 100. In altre parole, secondo lo studio di Giglietto, la politica non ha perso appeal spontaneamente, ma è stata resa meno centrale nella conversazione pubblica.

Nel gennaio 2025, quando Zuckerberg annuncia negli Stati Uniti la fine del cosiddetto 3Pfc e la rimozione di diverse misure di moderazione che negli anni precedenti avevano compresso i contenuti politici «le visualizzazioni dei contenuti politici esplodono». Un dato che conferma l’importanza di garantire la trasparenza dei processi. In questo contesto il Digital services act è un baluardo fondamentale «per normare l’accesso ai dati delle piattaforme da parte di ricercatori», conferma Giglietto: «Senza un adeguato accesso ai dati da parte di studiosi esterni non è possibile avere evidenze empiriche forti su cui basare scelte politiche o legislative». Ma non si tratta di una malcelata resistenza delle piattaforme, è un problema strutturale e tecnico, infatti «certe volte – spiega – abbiamo un’idea semplicistica: le piattaforme hanno i dati, ma non ce li vogliono dare. Ecco, non è esattamente così, le piattaforme hanno i dati utili al loro core-business, ma spesso in dei formati inutili per come un ricercatore li potrebbe utilizzare».

Polarizzazione e disinformazione non sono il risultato dell’operato dei fact-checker, ma dinamiche radicate nella natura umana, rese ancora più pervasive da piattaforme digitali progettate per massimizzare viralità e coinvolgimento emotivo. Di fronte a un fenomeno così diffuso, nessun attore può agire da solo. La complessità del problema richiede un’azione coordinata e trasversale.

Serve un confronto strutturato tra media, giornalisti, istituzioni, ricercatori ed esperti di cybersicurezza per immaginare soluzioni condivise, capaci di rafforzare l’ecosistema informativo e proteggere l’intelligenza cognitiva collettiva. Il quadro si espande, dalla dipendenza social delle nuove generazioni, all’insicurezza del web e l’impatto delle Ia, e le domande si moltiplicano: come può la cybersicurezza contrastare le molte forme di manipolazione digitale? Come difendere l’integrità delle democrazie se lo spazio pubblico online amplifica le nostre reazioni più impulsive? E come può il mondo dell’informazione resistere alla pressione degli algoritmi e allo squilibrio economico con le Big Tech? Sono domande che non riguardano soltanto gli addetti ai lavori, ma chiamano in causa tutti. Solo un impegno comune può generare risposte all’altezza della sfida.

LEGGI ANCHE

L'E COMMUNITY

Entra nella nostra community Whatsapp

L'edicola

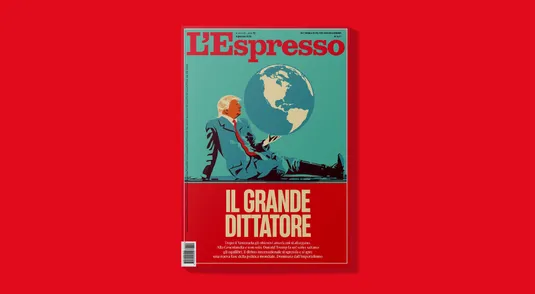

Il grande dittatore - Cosa c'è nel nuovo numero de L'Espresso

II settimanale, da venerdì 9 gennaio, è disponibile in edicola e in app